Gesundheitsberufe brauchen Praxis. Doch wie kann man üben, ohne Risiken einzugehen? Virtual Reality (VR) und Augmented Reality (AR) schaffen sichere Lernräume, in denen Handlungen, Kommunikation und Empathie erlebbar werden. Daneben eröffnen VR und AR neue Perspektiven und verbinden die Theorie mit der Praxis.

In Kürze zum Hören

Gesundheitsberufe benötigen Übungsgelegenheiten

Pflege bedeutet, im jeweiligen Moment richtig zu handeln. Da müssen nicht nur die Handgriffe sitzen, oft kommt es auch auf das richtige Wort zur richtigen Zeit an. Damit das gelingt, braucht es Vorbereitung und Übung, bevor es in die Praxis geht. In Skills-Trainings werden Abläufe eingeübt und reflektiert. Virtuelle Lernräume erweitern diese Trainings: Sie erlauben es, sicher zu trainieren, Fehler zu machen und daraus zu lernen.

Peer-Lernen durch Augmented Reality

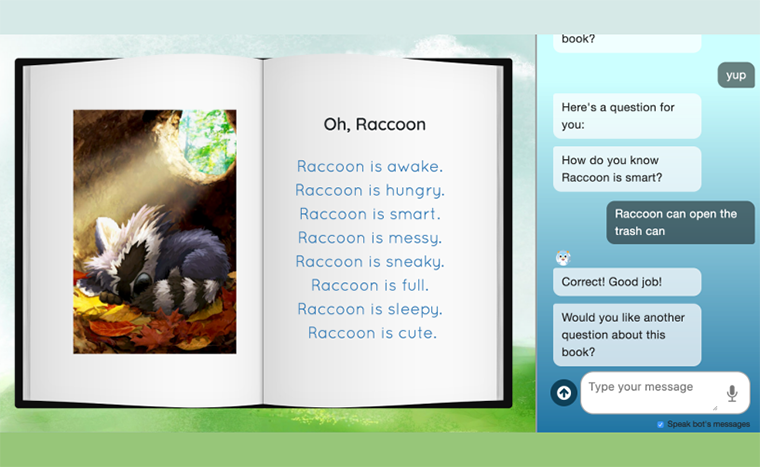

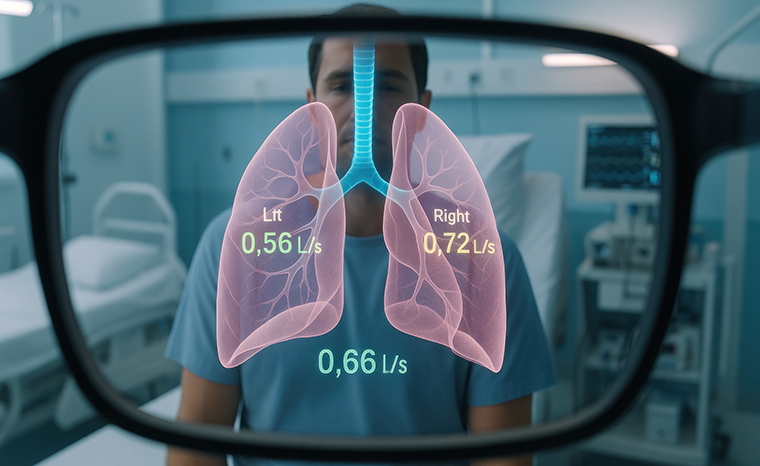

Augmented Reality (AR) verbindet reale und virtuelle Elemente. Lernende sehen eine reale Umgebung und gleichzeitig digitale Einblendungen. So lassen sich medizinische Untersuchungen und ihre Zusammenhänge Schritt für Schritt nachvollziehen.

An der Careum Hochschule für Gesundheit kommt im Modul «Clinical Assessment» die Anwendung CareTrain (1) zum Einsatz. Mit einer HoloLens (AR) wird ein virtuelles Herz auf den Oberkörper der Studierenden projiziert. Während sie mit dem Stethoskop den Herzschlag abhören, sehen sie in der AR-Darstellung, wie sich das Herz bewegt und das Blut fliesst. In der App lassen sich verschiedene Krankheitsbilder einstellen. So kann man Fehlfunktionen sowohl hören als auch im offenen Herzen sehen.

AR macht Unsichtbares sichtbar und verbindet Hören, Sehen und Verstehen.

Diese Kombination von auditiver und visueller Information schafft ein neues Verständnis: Studierende erkennen, was hinter einem Geräusch steckt, und besprechen ihre Beobachtungen gemeinsam. AR fördert dadurch Wissen, Austausch und Teamlernen.

Blick durch die AR-Brille mit CareTrain

VR-Simulationen für Pflegeabläufe

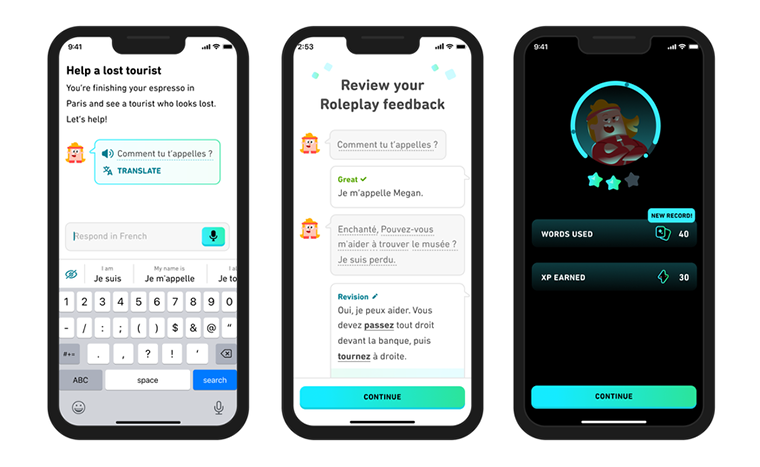

Virtual Reality (VR) schafft vollständig digitale Lernräume. Mit einer VR-Brille tauchen Studierende in realitätsnahe Pflegesituationen ein. Sie bewegen sich durch virtuelle Patientenzimmer, sprechen mit Patientinnen und Patienten, interagieren mit Geräten, lernen Handlungsabläufe kennen und treffen Entscheidungen, die den weiteren Verlauf beeinflussen.

Im Unterricht auf Stufe Höhere Fachschule HF wird am Careum die Anwendung UbiSim (2) eingesetzt. Das Training simuliert beispielsweise den Ablauf einer Bluttransfusion. Während der Behandlung klagt die Patientin plötzlich über Beschwerden. Die Studierenden müssen richtig reagieren, Symptome erkennen und Massnahmen einleiten.

Solche Szenarien lassen sich beliebig oft wiederholen und anpassen. Dadurch können konkrete Abläufe gefahrlos geübt und Routinen verinnerlicht werden. Nach der Simulation folgt eine strukturierte Nachbesprechung, in der die Studierenden ihr Handeln gemeinsam reflektieren.

VR erlaubt es, kritische Situationen realistisch zu erleben und sicher zu meistern.

Screenshot aus UBISIM

Die Ablaufsimulation ergänzt klassische Skills-Trainings um eine neue Dimension des Lernens. Sie verbindet praktisches Handeln mit unmittelbarem Feedback und fördert so Handlungssicherheit und Teamarbeit im Pflegealltag.

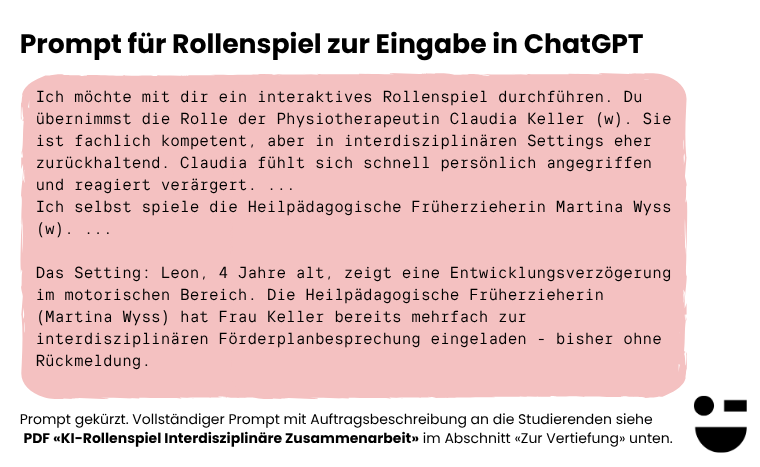

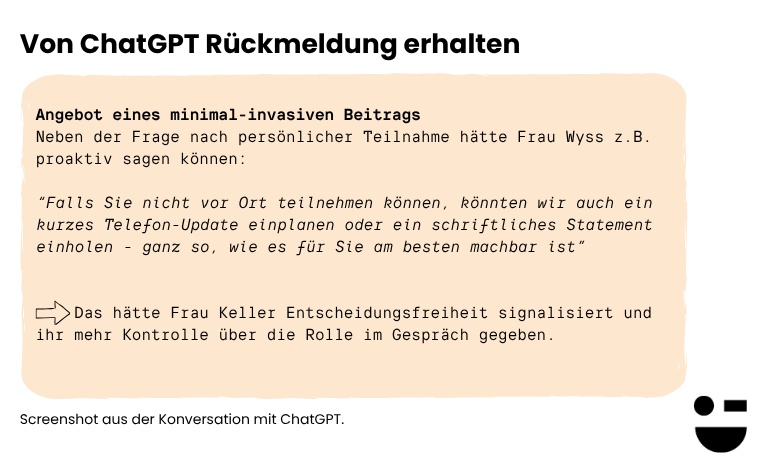

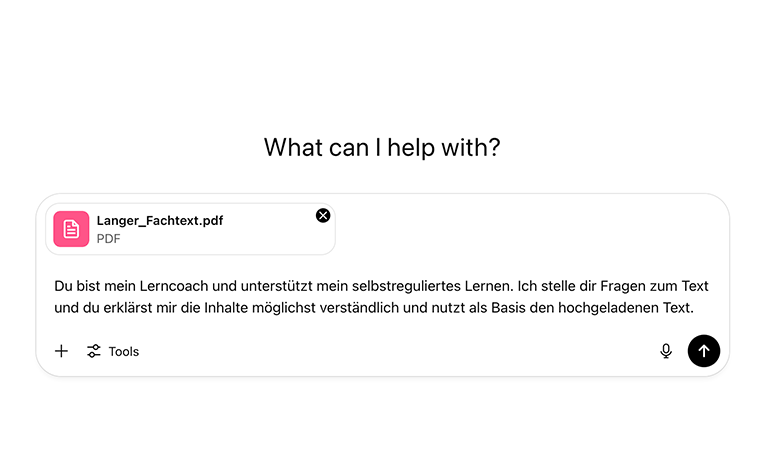

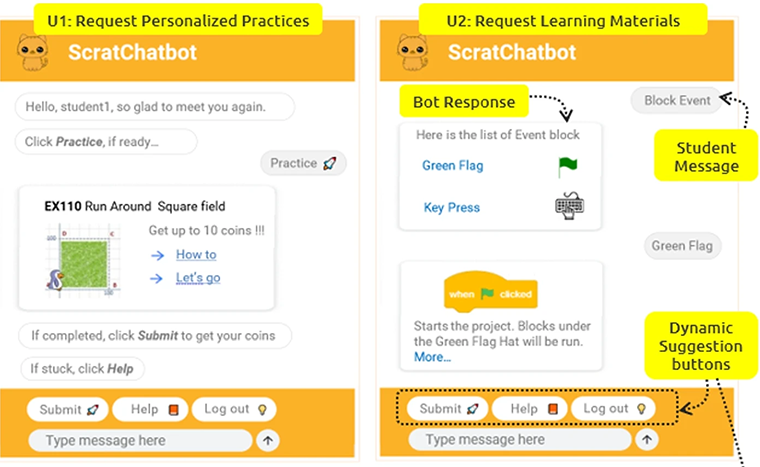

KI-Kommunikationstraining in VR und Browser

Für Kommunikationstrainings kommt die Anwendung 3spin Learning (3) zum Einsatz. Sie erweitert die Möglichkeiten virtueller Trainings und ermöglicht das Üben von Gesprächssituationen mit Unterstützung von künstlicher Intelligenz.

Screenshot aus 3Spin

Obwohl dieses Training auch mit VR-Brille möglich ist, wird es oft im Browser durchgeführt. In der Vorbereitung auf ihre Module an der Hochschule lernen Studierende verschiedene Kommunikationsmethoden kennen, etwa die Gewaltfreie Kommunikation nach Rosenberg (4), das Motivational Interviewing oder Strategien zum Überbringen schlechter Nachrichten. In der 3spin-Anwendung können realitätsnahe Gesprächssituationen erstellt und realitätsnah, zeit- und ortsunabhängig geübt werden.

KI und VR schaffen neue und zugängliche Räume für Kommunikation und Feedback.

Über den Browser betreten die Studierenden eine virtuelle 3D-Umgebung und führen über das Mikrofon in natürlicher Sprache ein Gespräch. Die KI reagiert in Echtzeit und übernimmt die Rolle der Gesprächspartnerin oder des Gesprächspartners. So lassen sich Situationen beliebig oft durchspielen und ohne Schauspielerinnen und Schauspieler gefahrlos üben.

Ein integrierter KI-Coach analysiert im Anschluss den Verlauf des Gesprächs und gibt individuelles Feedback. So werden Kommunikationskompetenzen praxisnah trainiert und das eigene Verhalten kann unmittelbar reflektiert werden. Im Unterricht folgt eine umfassendere Analyse sowie ein Vergleich mit echten Situationen.

Lernen durch immersives Eintauchen

Die bisherigen Erfahrungen zeigen, dass virtuelle Lernumgebungen bei den Studierenden auf grosses Interesse stossen. Sie motivieren und regen zum aktiven Lernen an. Die Integration in den Unterricht verlangt zusätzliche Planung sowie technische und didaktische Vorbereitung, bietet dafür aber wertvolle Impulse für die Weiterentwicklung der Ausbildung. Entwicklung gelingt, wenn man mutig ausprobiert und aus Erfahrungen lernt.

VR im Einsatz bei Careum

Sehr aktiv in dieser Entwicklung sind das Bildungszentrum Gesundheit und Soziales (BGS) Chur und die Berufsfachschule Gesundheit und Soziales (BFGS) Aarau, mit denen das Careum einen intensiven Austausch pflegt. Auch ausserhalb der Pflege diese Entwicklung Anklang. Organisationen wie Schutz & Rettung Zürich nutzen Simulationen, um Einsätze realitätsnah zu trainieren. Solche Anwendungen verbinden Wissen, Handeln und Empathie auf neue Weise.

Virtuelle Realität (VR), erweiterte Realität (AR) und künstliche Intelligenz (KI) schaffen neue Lernräume. Sie machen Theorie erlebbar, fördern Sicherheit und eröffnen Perspektiven, die im realen Unterricht kaum möglich wären. Das Gesundheitswesen steht damit am Anfang einer spannenden Entwicklung: Lernen wird immersiv, interaktiv und individuell.

Autoren: Dave Schneider & Reto Schürch, Careum Stiftung, Abteilung Strategie und Innovation, Zürich. Careum Hochschule Gesundheit

21.11.25

Zur Vertiefung

- CareTrain Augmented-Reality-Anwendung zur Herzauskultation im Modul Clinical Assessment. Visualisiert Herzbewegung, Blutfluss und Anatomie in Echtzeit und verknüpft auditives und visuelles Lernen.

- UbiSim Virtual-Reality-Plattform für Pflegesimulationen. Ermöglicht das sichere Üben von klinischen Abläufen wie Bluttransfusionen und unterstützt Reflexion im Team.

- Spin Learning KI-gestütztes Kommunikationstraining in VR und Browser. Studierende führen Gespräche mit KI-Agents in virtueller Umgebung und erhalten Feedback von einem integrierten KI-Coach.

- Marshall Rosenberg. Gewaltfreie Kommunikation.

Siehe auch den LernTechTrend-Beitrag «Virtuelle Welten fürs Lernen»

Feedback

Vielen Dank für deine Bewertung.